“Comment le SEO et Google vont changer votre perception du monde.”

Le SEO (Search Engine Optimization), en général, fait aujourd’hui l’objet de nombreuses rumeurs et de croyances quant à son utilité ou son efficacité.

Pourtant, les faits sont là ! Et alors que ses effets sont effectivement mesurables, via Google, quoi de mieux que des chiffres provenant des “Majors" de l’industrie pour dresser un portrait réaliste de la situation en général et du futur à venir…

Dis Google, dis-moi ce que tu sais … !

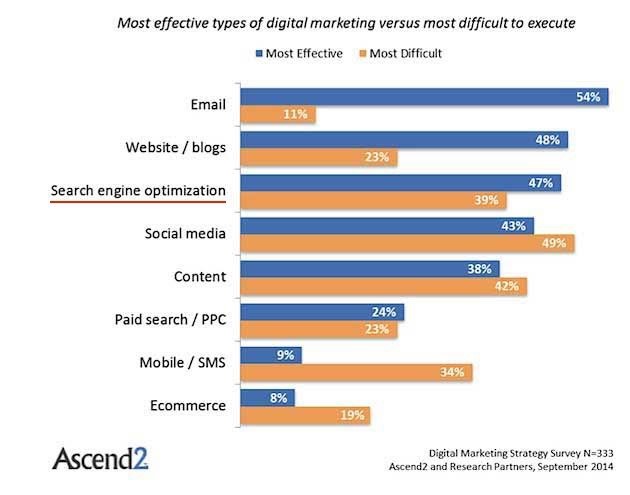

Saviez-vous que, selon Ascend2, 47 % des spécialistes en marketing digital affirment que le SEO est une de leurs tactiques les plus efficaces, mais 39 % l’identifient aussi comme une des plus difficiles.

Selon eMarketer, seuls 33 % des petites et moyennes entreprises ont des sites web optimisés SEO. Et on parle ici d’une statistique mondiale et aussi, du strict minimum effectivement en matière d’optimisation (comprenez ici une situation où Google a compris ce que vous faites et vous liste postivement selon des mots-clés associés à votre niche de marché).

Les moteurs de recherche (Google).

Alors que la majorité des personnes (et agences), lors de la création d’un site Web, concentre leur énergie sur des éléments à prédominance esthétique (sans pour autant favoriser l’UX, étrange paradoxe purement subjectif), au détriment de son optimisation effective (entendez la clarification de son contenu), selon imForza, 93 % des expériences en ligne commencent avec les moteurs de recherche. Autrement dit, la première expérience que le Web aura avec votre site émanera d’un moteur de recherche, d’où l’importance de penser indexation et capacité d’indexation lors de sa conception. D’ailleurs, selon Andrey Lipattsev, stratégiste en qualité de la recherche chez Google, les liens, le contenu et le RankBrain sont les trois signaux de positionnement les plus importants dans l’algorithme de recherche de Google (Search Engine Land).

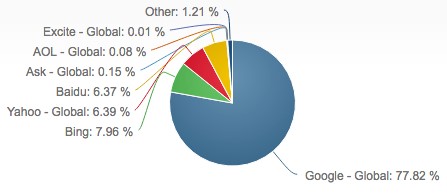

Petits bonus, saviez-vous que selon NetMarketShare, Google représente 78 % du trafic de recherche sur desktop, suivi par Bing (8 %), Yahoo (6 %) et Baidu (6 %) et que Google représente plus de 94 % du trafic de recherche sur mobile, suivi par Yahoo (3 %) et Bing (1 %).

Donc, quand vous entendez quelqu’un vous dire que vous devez impérativement diversifier votre indexation, multiplier votre présence sur plusieurs moteurs de recherche (incluant la publicité payante, …), … Théoriquement, il n’a pas tort. Tout investisseeur vous dirait qu’il est crucial de diversifier son portefeuille d’investissement. Dans les faits, c’est TOTALEMENT inutile et il vous faut l’accepter. Google est le plus important moteur de recherche sur le WEB, le plus populaire, et gagne tous les jours, toujours plus de parts de marché. Donc, dans l’optique où vous voulez être vu et qu’on vous trouve, pensez à GOOGLE et vous aurez fait une énorme partie du travail.

GOOGLE n’en a pas fini de vous surprendre !

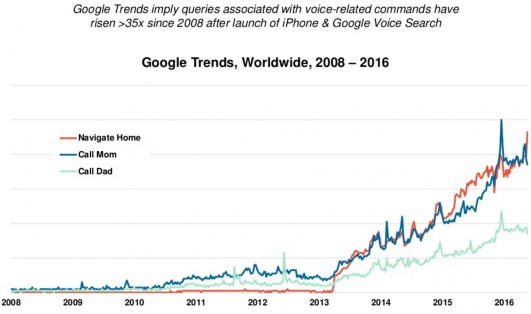

Il y a une autre tendance qui est en train d’émerger et qui risque d’en surprendre plus d’un ! Selon Search Engine Land, les recherches vocales faites sur Google ont augmenté de 10 % par rapport au volume de recherche global en 2016.

Et toujours selon eux, 50 % de toutes les recherches seront vocales d’ici 2020 (c’est juste dans 3 ans…).

L’aviez-vous vu venir ? Les 5 prochaines années risquent donc de voir apparaître une multitude de nouvelle technologies (et techniques) pour justement offrir des solutions adaptées à cette réalité. Et on ne parle même pas de l’importance, plus forte encore, qu’occupera le SEO dans les prochaines stratégies de référencement. Pourquoi? Parce que le “Medium" (en référence à une phrase emblématique “The medium is the message" de la pensée de Marshall McLuhan, philosophe des medias canadien, que j’ai personnellement adoré lire et étudier) aura totalement changé et la récupération de l’information sera différente, plus synthétique et surtout plus hiérarchisée.

Toutes les projections sont possibles et je ne veux pas me perdre en conjoncture mais, à l’heure actuelle, en tant que “texte" qui s’affiche sur un écran (ordinateur, tablette, …), notre esprit dispose d’une assez grande capacité d’absorption d’information. Même si elle est sélective, et parfois très subjective en dépit du contenu qui est proposé, sur un écran, nous avons la capacité d’intégrer une grande quantité d’information et nous choisissons plus largement, selon nos habitudes, l’information qui convient le plus à notre recherche. Dans le cas d’une distribution vocale de l’information, le temps devient un facteur beaucoup plus important (non pas dans le temps passé à lire l’information mais plutôt le temps à choisir l’information qui va être lue en priorité). Combien de temps faudra – il à une “intelligence" vocale pour lire le contenu d’une page entière de résultats Google (comptant une moyenne de 1900 mots) ?

Parions que la priorité sera mise sur l’information à fort potentiel d’efficacité (donc les premiers résultats) et c’est encore plus vrai au niveau SEO Local !

On peut donc encore s’attendre à de profondes modifications (améliorations) dans la manière dont l’information, en fonction de son référencement, sera présentée par Google (et donc, à une nécessité toujours plus croissante dans les besoins futurs d’optimisation) afin d’offrir le plus précisément possible l’information correspondant à la requête. Ceci étant, la manière dont l’information sera recherchée (ou demandée), sera aussi possiblement différente et probablement plus étoffée, nous sommes plus souvent volubile à l’oral qu’à l’écrit (qui constitue encore de nos jours un obstacle pour une grande partie de la population).

On peut également s’attendre à des requêtes plus riches en mots-clés et donc à des recherches plus ciblées… Un dossier à suivre de près !

Quelques stats supplémentaires.

À titre purement informatif, saviez-vous que, selon Internet Live Stats, Google reçoit plus de 58 000 recherches par seconde tous les jours, ce qui fait près de 2 mille milliards de recherches par an (en croissance continue) et que, selon Search Engine Land, rien que cette année, 100 millions d’heures de contenu « how-to » ont été regardées sur YouTube ?

Et pour ceux qui ne jurent que par les médias sociaux, comme outils de promotion, saviez-vous, toujours selon Search Engine Land, que les moteurs de recherche attirent 10 fois plus de trafic vers les sites e-commerce que les médias sociaux.

Autrement dit, un site web optimisé, avec sa propre boutique en ligne attirera, de manière organique, plus de visiteurs que toutes les promotions et autres campagnes, que vous pourriez mener sur les médias sociaux….

Quid des utilisateurs ?

En dépit des nombreuses recommandations, formations et autres tutoriels à disposition, il est une problématique que nous, tout un chacun, avons du mal à prendre en considération lorsque nous concevons un site Web. Peut-être est ce d’ailleurs symptomatique de notre état d’esprit généralisé. Nous valorisons souvent l’esprit de communauté dans une société, l’échange, le partage, mais souvent, nous en revenons à notre stricte individualité.

Je parle ici de l’empathie, du manque d’empathie sur le Web (à croire que, par défaut, nous avons des tendances sociopathes une fois devant l’écran d’un ordinateur).

Les plus grands succès Web de notre époque ont tous un point commun, en dehors du facteur technologique et accessoirement de l’Effet Grégaire, c’est une prise de conscience de l’environnement dans lequel se situe l’objet (réel ou virtuel) et de son interaction avec celui-ci. On ne parle pas ici de Marketing, qui se veut davantage linéaire, ordonné et caricaturale mais plutôt d’un concept de mise en abyme, et d’une capacité à analyser, tester, modeler, rationnaliser cet environnement pour l’amener à interagir de manière multilatérale avec l’objet en question (Growth Hacking).

Voici justement quelques faits mesurés et avérés qui témoignent de cette réalité:

Selon imForza, 70 % des résultats de recherche cliqués sont organiques, ORGANIQUES (donc pas Adwords, pour ceux qui investissent des fortunes en campagnes publicitaires).

De plus, toujours selon le site, il a été prouvé que plus de 75 % des utilisateurs de moteurs de recherche ne cliquent pas plus loin que la première page (la page 2 n’existe tout simplement pas).

Mais là où ça devient intéressant, et je fais le corollaire avec certaines débats récents qui ont animé la toile sur le positionnent factices de sites Web sur quelques combinaisons (mots-clés) comme “pseudoperformance" d’optimisation, c’est que selon WordStream, 50 % des requêtes de recherche comptent au moins quatre mots, 4 ! Ce qui témoigne d’autant plus de la nécessité, dans un concept d’optimisation de site Web, d’accroître significativement sa capacité d’indexation effective et son effet de résonance, plutôt que de, coûte que coûte, le positionner sur quelques mots-clés.

C’est un accroissement global de l’indexation d’un site qui générera à terme une amélioration de son référencement.

D’ailleurs, selon Earnest, 81 % des cycles de commande B2B débutent avec la recherche web. Donc, si vous êtes une entreprise orientée B2B, comprenez ici le message qui consiste à maximiser vos efforts d’optimisation au niveau Web (GOOGLE), et non dans un enchevêtrement obscure d’initiatives pseudo-stratégiques, combinant Ad Nauseam, l’ensemble des médias sociaux existant sur le Web. Il ne s’agit pas ici de dénigrer les réseaux sociaux, que du contraire ! Il convient de les utiliser pour leur force (service à la clientèle, stratégie de loyauté, référencement par l’indexation de liens en “DOFOLLOW", …) mais pas de manière exclusive !

Parlons maintenant du contenu, les MOTS !

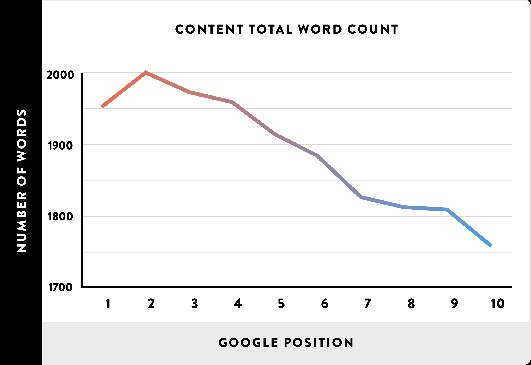

Une première statistique qui vous mettra directement sur la voie. Saviez-vous que, selon Backlinko, la première page de résultats sur Google contient 1890 mots en moyenne.

De quoi s’agit-il ? En matière d’optimisation, lors de la création de Titres et Meta Descriptions, il est souvent recommandé de les optimiser tant sur leur composition (à des fins de référencement) mais également sur leur longueur (ce qui va de soi, dans un contexte où on cherche à en optimiser le contenu). Respectivement, donc, on cherchera à optimiser son titre SEO jusqu’à 70 caractères et sa Meta Description, jusqu’à 160 caractères (qui sont des stricts maximum vu que, de toute façon, les moteurs de recherche et, arrêtons-nous seulement à Google, n’affichent pas plus que ces quantités respectives dans ses résultats). Compte tenu du fait que Google affiche, par défaut, 10 résultats par page, si on combine 70 et 160 (qui sont les maximums qu’on peut afficher), soit 230 caractères par site affiché, pour 10 sites listés, nous arrivons à 2300 caractères. Si on considère comme acceptable, des titres SEO affichant minimalement 50 caractères et des META description 140 caractères, donc 190 caractères au total, nous arrivons à une moyenne de 1900 mots par page.

Autrement dit, vu qu’il s’agit d’une moyenne relativement haute, on peut dire que les sites bénéficiant en général d’un bon positionnement sur Google, disposent tous de titres SEO et META descriptions relativement longs. Toutefois, si on suit la logique de ce graphique, les sites dont les titres SEO et META description ont été créé à leur capacité maximal, ont tendance à s’afficher en seconde page. Cela doit probablement prendre en considération ceux qui excèdent les maximum, donc ceux qui ont introduit trop de texte, sans rationaliser l’espace autorisé (concrètement, leurs titres SEO et META description comportent des mots-clés mais possiblement dilués dans la quantité de mots). Donc, en résumé, si en faisant une recherche sur Google à propos de votre site, vous voyez en titre SEO le mot “Accueil" et en META Description “Un site d’affaires" et que vous vous demandez encore pourquoi, votre site ne se positionne pas favorablement dans les résultats de recherche, vous avez maintenant un élément de réponse, statistique à l’appui.

Mais il y a plus encore! Une autre statistique intéressante provenant de Dilate, nous apprend que 99 % des sites top 10 (ranking) ont utilisé des META descriptions dans leurs stratégies d’optimisation, et 80 % ont utilisé des balises H1 dans leur contenu.

Il y aurait fort à dire relativement à cette dernière statistique. La META description paraît évidente (même si une grande partie des sites que j’analyse n’en comporte pas : 1 sur 3 pour être précis) mais pensez toujours à intégrer des balises H1 (Max 2) et H2, dans vos pages, idéalement selon un ordre hiérarchique, et plus particulièrement en page d’Accueil ! Les h1 pour définir votre identité et grossièrement, votre niche de marché, les H2, pour définir explicitement votre offre de service. Réservez tous les autres titres aux balises H3 !

Une petite astuce…

Saviez-vous que selon Backlinko, mettre à jour et republier d’anciens posts de blog avec du nouveau contenu et de nouvelles images peut augmenter votre trafic organique jusqu’à 111 %. N’effacez donc pas vos anciennes publications ! Prenez quelques minutes de temps en temps, faites-en la lecture, adaptez-les, apportez du nouveau contenu et republiez ! Une grande partie de votre indexation provient de vos articles de Blog. Parce qu’ils constituent souvent un moyen de contextualiser votre offre de service au travers de contenu connexe. Les effacer, c’est tout simplement accepter le fait de perdre volontairement du référencement.

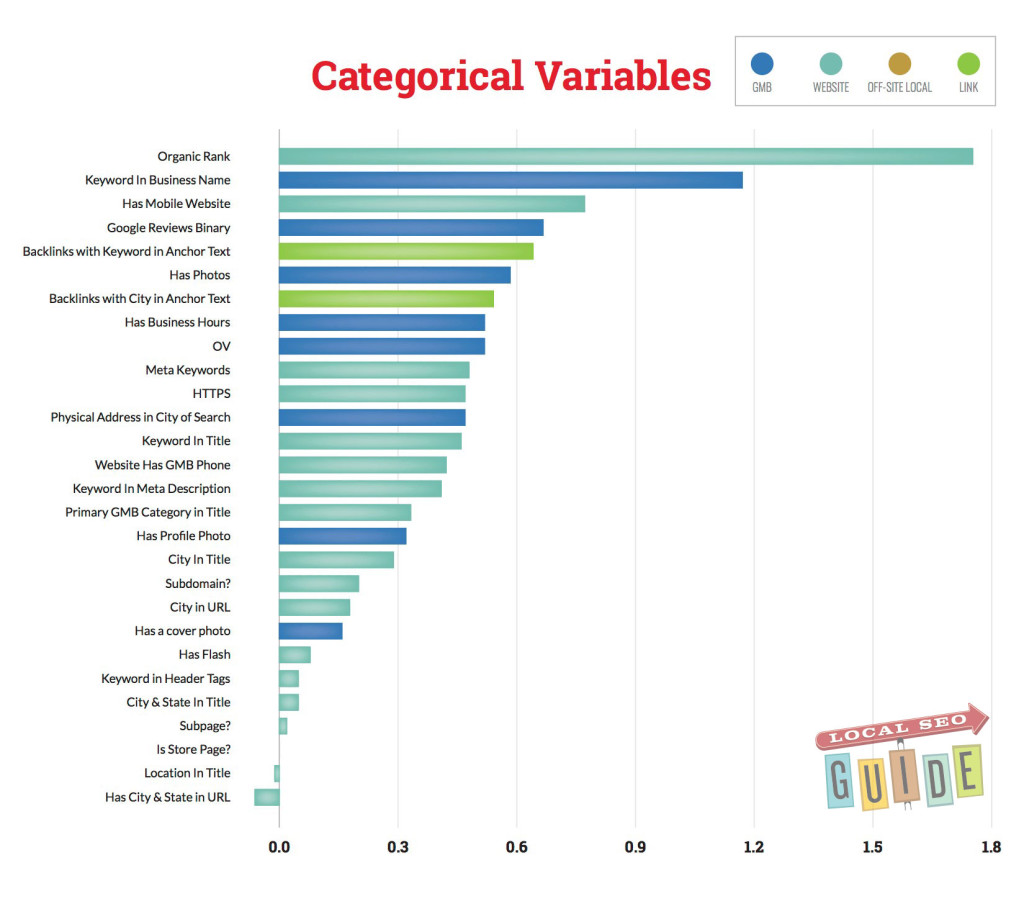

Une autre statistique que le “domainer" que je suis, apprécie par dessus-tout. Selon Local SEO Guide, les marques qui ont des mots clés forts dans leur nom (incluant donc, le nom de domaine) sont positionnées 1,5 place au-dessus de ceux qui n’ont pas de mot clé dans leur nom.

Autrement dit, le nom de votre marque et celui de votre nom de domaine jouent un rôle fondamentale pour votre référencement. Au moment de choisir, donc, évitez d’être trop créatif ! Allez vers ce qui vous définit. Même si l’impact reste “relatif", tâchez de mettre toutes les chances de votre côté !

Le contenu – Quelques statistiques

Saviez-vous que, en général, près de 50 % des sites ont des problèmes de contenu dupliqué.

En fait, le Top 5 des problèmes les plus fréquents en SEO OnPage sont: le contenu dupliqué (50 %), les attributs manquants (45 %), les balises dupliquées (35 %), les liens internes cassés (35 %), et les meta descriptions dupliquées (30 %).

Il y aurait plusieurs points à discuter ici mais le plus important, selon moi, c’est la duplication de contenu car de tous, c’est le problème qui peut causer justement le plus de tort à votre site Web. Il y a 2 manières dont le contenu peut-être vu comme dupliqué;

Soit via un problème de redirection 301 au niveau de votre nom de domaine. Donc, concrètement, vous n’avez pas identifié quel était le nom de domaine principal de votre site et donc, même si la version WWW et la version sans les WWW de votre site Web (ex: www.jefaisduseo.com et jefaisduseo.com) s’affichent correctement, elles sont pourtant perçues comme 2 entités distinctes (car en réalité, le WWW est un sous-domaine de votre nom de domaine). Ce qui est vu comme de la duplication de contenu (de site plus exactement) et est lourdement sanctionné par Google.

Soit, vous êtes un mauvais élève et vous avez copié du contenu provenant d’un autre site ! Si ce contenu a d’ores et déjà été indexé par Google, il considérera votre page comme une duplication (car il priorise avant toute chose, le contenu original) et sanctionnera votre site !

Concernant les liens internes, Google déteste les erreurs d’exploration, ou ce qu’on appelle les erreurs 404. Soit des liens de votre site ne menant à … rien. Plus votre site en a, plus vous perdez du référencement ! Tout simplement parce que votre site perd sa crédibilité. Google n’aime pas proposer des Pages en 404 (et donc des sites qui en comportent), parce que fondamentalement, ça va à l’encontre de sa mission première, qui consiste à fournir la réponse la plus adaptée à une requête ! Pensez donc à faire occasionnellement un examen de vos liens, soit par un outil de diagnostique, soit directement dans la Console Google !

Quelques stats en rafale concernant le WEB mobile (et l’importante du responsive).

- Selon Reuters, 75 % de l’usage d’Internet sera mobile en 2017, en légère hausse par rapport à 2016.

- Selon Social Media Examiner, 62 % des spécialistes en marketing B2B et 51 % des spécialistes en marketing B2C ont optimisé leurs blogs pour le mobile afin d’améliorer le SEO.

- Selon Search Engine Land, plus de 50 % des utilisateurs effectuent leurs recherches sur des appareils mobiles.

- Selon Search Engine Watch, en 2016, Google a produit 90 % des visites issues de recherche mobile organique. De plus, la part que Google occupe en matière de recherche organique mobile, a augmenté de presque deux points l’année dernière.

- Enfin, selon Go-globe, 87 % des propriétaires de Mobile utilisent un moteur de recherche au moins une fois par jour.

Est ce que votre site Web est responsive ? Vous pouvez faire le test ici : https://search.google.com/test/mobile-friendly . Si ce n’est pas le cas, vu la prédominance de l’utilisation du mobile dans les années à venir, vous savez ce que vous avez à faire. Depuis 2015, Google sanctionne toujours plus lourdement les sites Web non responsive et ça risque de s’amplifier avec le temps.

Qu’est-il du SEO local ?

On parle ici, outre l’optimisation effective de votre site pour le positionner dans votre environnement direct, de Google Map, de Google My business, etc…. Comment les utilisez-vous ? Apparaissez-vous sur la Map quand vous faites une recherche locale ?

Voici quelques statistiques:

Selon WordStream, 72 % des consommateurs ayant effectué une recherche locale se sont rendus dans un magasin physique situé dans un rayon de 8 km. Vous l’avez compris, on voit absolument tout et de manière très distinctement correlée, via un cellulaire (et la fonction GPS), entre une recherche et le déplacement effectif de la personne à posteriori.

Selon Go-globe, 18 % des recherches locales sur mobile conduisent à une vente dans la journée et 50 % des recherches locales sur mobile visent des informations de type business telles que l’adresse de l’entreprise recherchée.

Enfin, selon Search Engine Land, 82 % des utilisateurs font appel à un moteur de recherche quand ils recherchent une entreprise locale.

Le SEO dans le monde

Pour conclure, voici quelques stats qui vont très probablement vous étonner ! Et peut-être remettre en question votre vision du monde et de certaines tendances…

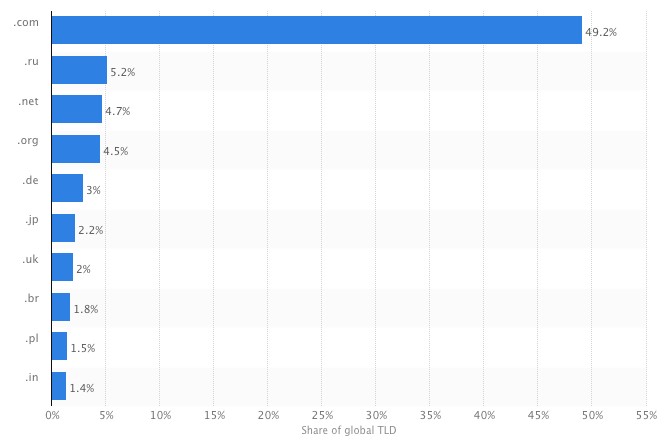

Saviez que selon Statista, le Top 5 des TLDs (Top Level Domains) les plus populaires en juin 2016 sont : .com (49,2 %), .ru (5,2 %), .net (4,7 %), .org (4,5 %), .de (3 %).

Évitez donc de vous empresser à acquérir l’une de ces nouvelles extensions (GTLDs: .pro, .city, .top, .xyz, …). Même si elles peuvent paraitre effectivement attractives, l’énorme majorité de la population ne les perçoit pas de la même manière que les TLDs traditionnels ! Il faudra encore probablement quelques années avant que ceux-ci ne commencent effectivement à occuper plus sérieusement le devant de la scène. De plus, il n’a pas été prouvé qu’ils affectaient positivement le référencement (en dépit de toutes les spéculations sur le sujet). Certains joueurs majeurs, au niveau Web, ont certes franchis le cap, mais d’autres en sont revenus. À bon entendeur …

Selon Hootsuite, le Top 3 des pays avec le meilleur taux d’accès à l’Internet en 2017 sont : les Émirats arabes unis (99 %), l’Islande (98 %), la Norvège (97 %). Et, toujours selon le site, 50 % du trafic web dans le monde entier est réalisé sur mobile, 45% sur desktop et 5% sur tablette.

Selon Statista, le Top 5 des pays avec la vitesse de connexion Internet la plus élevée dans le monde est : la Corée du sud – 26.3, la Chine (Hong Kong) – 20.1, la Norvège – 20, la Suède – 19.7 et la Suisse – 18.4.

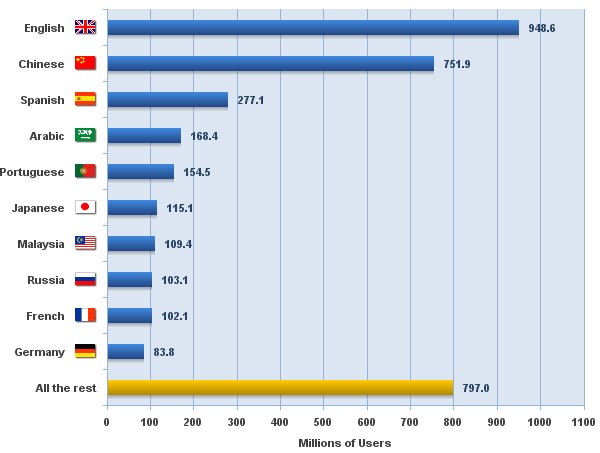

En enfin, selon Internet World Stats, le Top 5 des langues utilisés sur Internet sont l’anglais (948.6 M utilisateurs), le chinois (751.9 M), l’espagnol (277.1 M), l’arabe (168.4 M) et le portugais (154.5 M).

Ha, une petite dernière pour la route, saviez-vous que le site web le plus traduit au monde (780 langues et dialectes) est celui des Témoins de Jéhovah (jw.org), suivi par Wikipédia (287 langues). (Pangeanic)

Source: https://www.semrush.com/blog/

Check this link for more info about SEO: https://ignitevisibility.com/seo-movie/